Questa è una traduzione italiana di AI Timelines: Where the Arguments, and the “Experts,” Stand.

Versione audio disponibile (in inglese) su Cold Takes (o su Stitcher, Spotify, Google Podcasts, ecc. come “Cold Takes Audio”).

L’articolo comincia con un riassunto di quando possiamo aspettarci che un’IA trasformativa venga sviluppata, sulla base di diversi punti di vista analizzati in precedenza. Penso che possa essere utile anche se avete già letto gli articoli precedenti, ma se volete saltarlo cliccate qui.

Rispondo poi alla seguente domanda: “Perché gli esperti non riescono ad arrivare a un consenso solido su questo tema e quali sono le conseguenze sulla nostra vita?”

Secondo le mie stime c’è più del 10% di probabilità che vedremo un’IA trasformativa entro i prossimi 15 anni (entro il 2036); una probabilità del 50% di vederla entro 40 anni (entro il 2060) e una del 66% di vederla in questo secolo (entro il 2100).

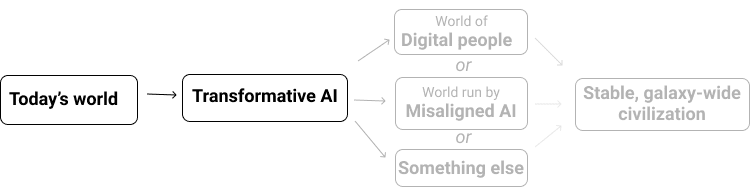

(Con “IA trasformativa” intendo “un’IA abbastanza potente da condurci verso un futuro nuovo e qualitativamente diverso”. Nello specifico mi concentro su ciò che chiamo PASTA: intelligenze artificiali che possono in pratica automatizzare tutte le attività umane necessarie ad accelerare il progresso scientifico e tecnologico. Sono dell’opinione che i sistemi PASTA da soli potrebbero essere sufficienti a fare di questo secolo il secolo più importante, sia per via di un possibile boom di produttività che per i rischi derivanti da IA non allineate.)

Questa in generale è la mia conclusione, sulla base di un certo numero di report tecnici che fanno previsioni sul futuro delle IA da diverse angolazione – molti dei quali prodotti da Open Philanthropy negli ultimi anni mentre cercavamo di sviluppare un’idea precisa delle previsioni sulle IA trasformative che arricchisse il nostro processo di grantmaking lungoterminista.

Di seguito trovate una tabella di riassunto dei diversi punti di vista sulle previsioni sulle IA trasformative che abbiamo discusso in passato, completo di link che rimandano a discussioni più approfondite in precedenti articoli e ai report tecnici a cui fanno riferimento.

| Tipo di previsione | Articoli di approfondimento (titoli abbreviati) | La mia sintesi |

| Stime probabilistiche per IA trasformativa | ||

| Sondaggio di esperti. Cosa si aspettano i ricercatori in IA? | Quando l’IA supererà le prestazioni umane? Le risposte degli esperti di IA | Un sondaggio di esperti implica una probabilità del ~20% entro il 2036; ~50% entro il 2060; ~70% entro il 2100. Domande leggermente diverse (poste a una minoranza di intervistati) danno stime molto più lontane. |

| Framework con riferimenti biologici (Biological anchors framework) Sulla base dei tipici modelli di costo dell’addestramento di IA, quanto costerebbe addestrare un modello di IA grande come un cervello umano per eseguire le cose più difficili che fanno gli esseri umani? E quando sarà abbastanza economico da potersi aspettare che qualcuno lo faccia? | Bio Anchors, sulla base di Brain Computation | Probabilità: > 10% entro il 2036; ~50% entro il 2055; ~80% entro il 2100. |

| Punto di vista dell’ onere della prova | ||

| È improbabile che un dato secolo sia il “più importante”. | Are We Living At The Hinge Of History? (Viviamo in un punto cardine della storia?); Risposta | Abbiamo molte ragioni per pensare che questo secolo sia un secolo “speciale” prima di esaminare i dettagli dell’IA. Molte sono state trattate negli articoli precedenti; un’altra è nella prossima riga. |

| Quali previsioni faresti sulle tempistiche dell’IA trasformativa, basandoti solo su informazioni di base su (a) da quanti anni si sta cercando di costruire un’IA trasformativa; (b) quanto si è “investito” in essa (in termini di numero di ricercatori di IA e di quantità di computazione utilizzata da questi ultimi); (c) se ci sono ancora riusciti (per ora, non ci sono riusciti)? | Semi-informative Priors (Probabilità a priori semi-informative) | Stime centrali: 8% entro il 2036; 13% entro il 2060; 20% entro il 2100. A mio avviso, questo articolo evidenzia che la storia dell’IA è breve, gli investimenti nell’IA stanno aumentando rapidamente e quindi non dovremmo sorprenderci troppo se presto verrà sviluppata un’IA trasformativa. |

| Sulla base dell’analisi dei modelli economici e della storia economica, quanto è probabile una “crescita esplosiva” – definita come una crescita annua dell’economia mondiale superiore al 30% – entro il 2100? È abbastanza al di fuori di ciò che è “normale” da dover dubitare della conclusione? | Explosive Growth, Human Trajectory | Human Trajectory (Traiettoria dell’Umanità) proietta il passato in avanti, implicando una crescita esplosiva entro il 2043-2065. Explosive Growth (Crescita Esplosiva) conclude: “Trovo che le considerazioni economiche non siano una buona ragione per scartare la possibilità che l’IA venga sviluppata in questo secolo. Anzi, esiste una prospettiva economica plausibile in base alla quale si prevede che sistemi di IA sufficientemente avanzati provocheranno una crescita esplosiva”. |

| “In che modo le persone hanno previsto l’IA… in passato, e dovremmo modificare le nostre opinioni oggi per correggere errori comuni che possiamo osservare nelle previsioni precedenti? … Abbiamo riscontrato l’opinione che l’IA sia stata soggetta ripetutamente di annunci eccessivi in passato, e che quindi dovremmo aspettarci che le proiezioni di oggi siano probabilmente troppo ottimistiche”. | Past AI Forecasts (precedenti previsioni sull’IA) | “L’apice dell’ottimismo sull’IA sembra essere stato nel periodo 1956-1973. Tuttavia, l’ottimismo implicito in alcune delle più note previsioni sull’IA di questo periodo viene spesso esagerato”. |

Disclaimer sulla trasparenza: molti di questi report tecnici sono analisi di Open Philanthropy, società di cui sono il co-amministratore.

Detto questo, immagino che alcuni lettori potrebbero sentirsi ancora un po’ a disagio. Anche se pensano che le mie tesi siano sensate, potrebbero pensare: se tutto questo è vero, perché non se ne parla molto di più? Qual è il consenso tra gli esperti?

Allo stato attuale, riassumerei il consenso tra gli esperti in questo modo:

- Ciò che affermo non è in contrasto con quello che pensano gli esperti in generale. (Al contrario, le probabilità che ho stimato non sono troppo lontane da quelle che fanno di solito i ricercatori nel campo dell’intelligenza artificiale, come si vede nella prima riga.) Ci sono tuttavia indizi che portano a credere che non stanno riflettendo abbastanza sulla questione.

- I report tecnici di Open Philanthropy su cui mi baso sono stati analizzati da esperti esterni all’organizzazione. Ricercatori nel campo del machine learning hanno valutato Bio Anchors; Brain Computation è stato esaminato dai neuroscienziati; gli economisti hanno esaminato Explosive Growth; professori e accademici nel campo delle probabilità/incertezza hanno esaminato Semi-informative Priors.[2] (Alcune di queste review hanno sollevato punti su cui si è in disaccordo, ma non ci sono stati casi in cui i report erano direttamente in contrasto con il consenso degli esperti o con la letteratura esistente.)

- Ma gli esperti non hanno ancora raggiunto un consenso chiaro e solido a sostegno di tesi come “C’è almeno il 10% di probabilità di avere un’IA trasformativa entro il 2036” o “C’è una buona probabilità che questo sia il secolo più importante per l’umanità”, non nel modo in cui c’è un consenso a sostegno, ad esempio, delle azioni volte a intervenire sul cambiamento climatico.

In definitiva, le mie affermazioni riguardano ambiti per i quali semplicemente non c’è un “pool” di esperti che si dedicano a studiarli. Già di per sé questo è preoccupante e spero che in futuro la situazione possa cambiare.

Nel frattempo, però, dovremmo concentrarci sulla teoria del “secolo più importante”?

Nel resto dell’articolo vedremo:

- Come potrebbe essere un “ambito di previsioni sulle IA”.

- Un “punto di vista scettico” secondo il quale le discussioni attuali su questi argomenti sono troppo ristrette, omogenee e isolate (cosa su cui sono d’accordo), motivo per cui non dovremmo concentrarci sulla teoria del “secolo più importante” fino a quando non esisterà un campo di ricerca ben consolidato (su cui non sono d’accordo).

- Perché penso che nel frattempo dovremmo prendere in seria considerazione questa teoria, fino a quando (e a meno che) non si crei un tale campo di ricerca:

- Non possiamo aspettare di avere un consenso solido sulla questione.

- Se esistono obiezioni valide – o esperti che potrebbero formulare obiezioni valide in futuro – non le abbiamo ancora trovate. Più questa teoria viene presa in considerazione e maggiori sono le probabilità che queste obiezioni verranno formulate in futuro. (Legge di Cunningham: “il modo migliore per ottenere una risposta corretta è formularne una sbagliata”.)

- Penso che continuare a insistere sul consenso degli esperti sia un modo pericoloso di ragionare. Sono dell’idea che sia accettabile correre il rischio di illudersi o isolarsi se ci porta a fare la cosa giusta quando è più necessario.

Che tipo di competenze richiedono le previsioni sulle IA?

Tra le domande analizzate nei report menzionati in precedenza troviamo:

- Le IA stanno sviluppando abilità sempre più notevoli? (IA, storia delle IA)

- Come possiamo confrontare i modelli di IA con il cervello umano/animale? (IA, neuroscienze)

- Come possiamo confrontare le abilità delle IA con quelle degli animali? (IA, etologia)

- In base alle informazioni di cui disponiamo sull’addestramento di precedenti intelligenze artificiali, come possiamo calcolare le spese necessarie ad addestrare un’intelligenza artificiale complessa per un compito difficile? (IA, curve fitting)

- Basandoci esclusivamente sugli anni/ricercatori/soldi impiegati in questo campo fino a ora, in che modo possiamo formulare una valutazione essenziale sulle IA trasformative? (Filosofia, studio delle probabilità)

- In base agli andamenti storici e alle teorie di cui disponiamo, quali sono le probabilità di un boom economico in questo secolo? (Scienze della crescita economica, storia dell’economia)

- Che genere di “hype per le IA” c’è stato in passato? (Storia)

In passato, quando ho parlato delle conseguenze su larga scala delle IA trasformative sul “secolo più importante”, ho preso in considerazione domande come “È realistico aspettarsi persone virtuali e la fondazione di colonie spaziali nella galassia?” Questi argomenti riguardano fisica, neuroscienze, ingegneria, filosofia della mente e molto altro.

Non esistono lavori o background precisi che facciano di qualcuno un esperto in grado di dire quando avremo IA trasformative o se questo è il secolo più importante per l’umanità.

(Io in particolare non sono d’accordo con chi afferma che per questo genere di previsioni dovremmo affidarci esclusivamente ai ricercatori nel campo delle intelligenze artificiali. Oltre al fatto che al momento non sembra stiano riflettendo granché sull’argomento, penso che affidarsi a persone che costruiscono modelli di IA sempre più potenti per sapere quando avremo IA trasformative sia come affidarsi a società che sviluppano tecnologie a energia solare – o a compagnie petrolifere, a seconda di come volete vederla – per fare previsioni sulle emissioni di carbonio e il cambiamento climatico. Hanno di sicuro un punto di vista sulla questione, ma fare previsioni è un lavoro diverso dal migliorare o costruire sistemi all’avanguardia.)

Non sono nemmeno sicuro che queste domande siano fatte per la ricerca accademica. Fare previsioni sulle IA trasformative o capire se questo è il secolo più importante sembra più simile:

- Al modello elettorale FiveThirtyEight (“Chi vincerà le elezioni?”) piuttosto che a discussioni accademiche di scienze poltiche (“Qual è la relazione tra governi ed elettori?”);

- Al trading nei mercati finanziari (“I prezzi si alzeranno o si abbasseranno?” che alle discussioni accademiche di economia (“Perché avvengono le recessioni?”);

- Alle ricerche di GiveWell (“Quale organizzazione benefica aiuterà più persone con questa somma di denaro?”) che alle discussioni accademiche di economia dello sviluppo (“Quali sono le cause della povertà e quali i fattori che la riducono?”)

Voglio dire che non mi è chiaro quali caratteristiche dovrebbe avere un’”istituzione” naturale per le competenze necessarie alle previsioni sulle IA trasformative e sul “secolo più importate”, ma mi sento di dire che attualmente non esiste nessuna grande istituzione che studia queste tematiche.

Come dovremmo comportarci in mancanza di un consenso tra gli esperti?

Il punto di vista scettico

Stante la mancanza di un consenso solido tra gli esperti, mi aspetto che alcune (o meglio, molte) persone saranno scettiche a prescindere dal tipo di argomentazione.

Quella che segue è una versione molto generica di una reazione scettica con cui sono solidale:

- Mi sembra tutto troppo fantasioso.

- Le tue affermazioni sul vivere nel secolo più importante sono esagerate. È uno schema cognitivo tipico delle illusioni.

- Dici che l’onere della prova non dovrebbe essere così rilevante perché ci sono molti elementi che indicano che stiamo vivendo un periodo eccezionale e incerto. Solo che… non mi ritengo in grado di valutare quelle affermazioni, o le tue affermazioni sulle IA, o qualsiasi altra cosa su questi argomenti assurdi.

- Mi preoccupa il fatto che ci sono poche persone che si occupano di questi temi e quanto ristretto, uniforme e isolato sembra il dibattito. In generale mi sembra che sia una storia che si raccontano quelli intelligenti per convincersi del loro posto nel mondo, con un sacco di grafici e cifre per razionalizzare il tutto. Non sembra “reale”.

- Okay, fammi un fischio quando ci sarà un campo di ricerca con magari centinaia o migliaia di esperti che si valutano ed esaminano a vicenda e quando questi avranno raggiunto un qualche tipo di consenso simile a quello che abbiamo per il cambiamento climatico.

Capisco perché possiate sentirvi così. Io stesso mi sono sentito così a volte, soprattutto sui punti 1 e 4, ma voglio illustrarvi tre motivi per cui penso che il punto 5 non sia corretto.

Motivo n.1: non possiamo permetterci di aspettare che si formi un consenso

La mia paura è che l’avvento delle IA trasformative sia un po’ una versione in slow motion e con una posta in gioco più alta della pandemia di COVID-19. Se ci basiamo sulle analisi e sulle informazioni migliori di cui disponiamo al momento, ci sono buone ragioni per aspettarsi che succeda qualcosa di importante, ma la situazione è decisamente singolare: non può essere catalogata in nessuno degli insiemi di situazioni che le nostre istituzioni affrontano regolarmente. Inoltre, prima cominciamo ad agire è meglio è.

Potremmo anche immaginarla come una versione accelerata delle dinamiche del cambiamento climatico. Pensate se le emissioni di gas serra avessero cominciato ad aumentare solo di recente (invece che a metà Ottocento) e non ci esistesse ancora una branca della scienza che si occupa del clima. Aspettare per decine di anni che nasca una tale branca prima di cercare di ridurre le emissioni sarebbe una pessima idea.

Motivo n.2: La Legge di Cunningham (“il modo migliore per ottenere una risposta corretta è formularne una sbagliata”) potrebbe essere il modo migliore per trovare falle in questi ragionamenti

No, sul serio.

Diversi anni fa, io e alcuni miei colleghi avevamo il sentore che la teoria del “secolo più importante” potesse essere corretta, ma prima di concentrarci tutte le nostre energie volevamo vedere se saremmo riusciti a trovarvi degli errori cruciali.

Un modo per descrivere come abbiamo lavorato negli ultimi anni è che sembrava che stessimo facendo tutto il possibile per capire che la teoria era errata.

Per prima cosa abbiamo discusso dei temi fondamentali con diverse persone: ricercatori nel campo delle IA, economisti, ecc. Sono sorti alcuni problemi:

- Avevamo solo idee molto vaghe delle argomentazioni in questo campo (perlopiù, o forse del tutto, estrapolate da altre persone). Non eravamo in grado di esporle con il giusto livello di chiarezza e meticolosità.

- C’erano un sacco di punti concreti che pensavamo si sarebbero rivelati corretti, ma che non avevamo identificato alla perfezione e che non potevamo presentare perché fossero esaminati.

- In generale, non eravamo nemmeno in grado di esporre un caso concreto con sufficiente chiarezza perché gli altri avessero la possibilità di demolirlo.

Ragion per cui abbiamo lavorato a lungo per creare report tecnici su molte delle argomentazioni fondamentali (che sono adesso di pubblico dominio e inclusi all’inizio di questo articolo), cosa che ci ha messo in condizione di pubblicare le argomentazioni e ci ha dato la possibilità di trovare controargomentazioni decisive.

A questo punto abbiamo richiesto review da parte di esperti esterni al nostro gruppo.

Limitandoci alle mie ipotesi, sembra che la teoria del “secolo più importante” abbiamo superato tutti i test. Dopo averla esaminata da ogni angolazione ed essere entrato più nei dettagli, infatti, credo ancora più fermamente che sia corretta.

Ma d’accordo, diciamo che è solo perché secondo i veri esperti – persone che non abbiamo ancora scovato e che hanno controargomentazioni potentissime – tutta questa faccenda è così stupida che non perdono nemmeno tempo a esaminarla. Oppure che ci attualmente persone che in futuro potrebbero diventare esperti di queste materie e demolire queste argomentazioni. Cosa potremmo fare perché si realizzi questa situazione?

La risposta migliore che ho trovato è: “Se questa teoria fosse più conosciuta, più accettata e più influente, allora verrebbe anche esaminata più spesso.”

Questa serie è un tentativo di andare in quella direzione, di portare maggiore credibilità alla teoria del “secolo più importante”. Sarebbe un’ottima cosa se questa teoria si rivelasse corretta; sarebbe anche il passo successivo più logico se il mio obiettivo fosse quello di mettere in discussione le mie credenze e scoprire che è sbagliata.

Ovviamente non sto dicendo che dovete accettare o promuovere la teoria del “secolo più importante” se non vi sembra corretta, ma penso che se il vostro unico dubbio riguarda la mancanza di un consenso diffuso, sembra un po’ strano continuare a ignorare la situazione. Se ci comportassimo sempre così (ignorando qualsiasi teoria che non è sostenuta da un consenso diffuso), non credo che vedremmo mai una sola teoria – anche quelle corrette – passare dall’essere di nicchia all’essere accettata.

Motivo n.3: in generale, lo scetticismo non sembra una buona idea

Quando lavoravo a GiveWell, le persone ogni tanto mi dicevo cose del tipo: “non puoi mica sottoporre ogni argomentazione agli stessi standard di qualità che GiveWell usa per valutare le organizzazioni benefiche – test randomizzati controllati, solide basi empiriche, ecc. Alcune delle migliori occasioni per fare del bene saranno per forza quelle meno evidenti, perciò c’è il rischio che questi standard escludano alcune delle più grandi occasioni per avere un impatto positivo.”

Sono convinto che sia così. Penso che sia importante controllare il proprio approccio al ragionamento e agli standard di evidenze scientifiche e chiedersi: “In quali situazioni questo metodo fallirebbe e in quali preferirei che avesse successo?” Per quel che mi riguarda, è accettabile correre il rischio di illudersi o isolarsi se ci porta a fare la cosa giusta quando è più necessario.

Penso che la mancanza di consenso tra gli esperti – e il timore di illudersi o isolarsi – siano buone ragioni per indagare a fondo la teoria del “secolo più importante” piuttosto che accettarla all’istante. Per chiedersi se ci possano essere errori non ancora individuati, per cercare bias che potrebbero esagerare la nostra importanza, per andare alla ricerca di quegli aspetti dell’argomentazione che sembrano più discutibili, ecc.

Se però avete esaminato la questione a un livello che vi sembra accettabile/fattibile – e non avete trovato altri difetti se non considerazioni del tipo “non c’è consenso diffuso” e “mi preoccupa la possibilità di illudermi o isolarmi” – allora direi che scartare quest’ipotesi farà sì che non sarete tra i primi a rendervi conto di e ad agire su un problema estremamente importante se se ne presenta l’occasione. Per quel che mi riguarda, se penso alle occasioni sprecate per fare del bene, è un sacrificio troppo grande.