Questa è una traduzione italiana di ‘Crucial Considerations and Wise Philanthropy’, by Nick Bostrom di Pablo.

Il 9 luglio 2014 Nick Bostrom ha tenuto un discorso su “Considerazioni cruciali e filantropia saggia” alla Good Done Right, una conferenza sull’Altruismo Efficace tenuta allo All Souls College di Oxford. Il discorso mi è sembrato così prezioso che ho deciso di trascriverlo.

Trascrizione completa

Questo discorso prende spunto da alcune delle idee di cui Nick Beckstead stava parlando prima di pranzo. Al contrario della sua presentazione, però, questo discorso non sarà così scorrevole.

È un work in progress, per cui ci sarà qualche parte solo accennata, qualche punto in cui non si capisce bene, ecc. Ma non vedo l’ora di discuterne.

Cosa intendiamo per “considerazione cruciale”?

Vi voglio parlare del concetto di considerazione cruciale, concetto che incontriamo spessissimo nel nostro lavoro. Immaginate di essere in un bosco. Avete una mappa e una bussola e state cercando di trovare la strada per la vostra meta. Avete parecchio peso con voi (diciamo che avete molta acqua perché per raggiungere il vostro obiettivo e sostenere il peso dello zaino dovete idratarvi) e state cercando di capire con precisione in quale direzione state andando. State anche cercando di capire quanta acqua potete lasciare per alleggerirvi senza che ve ne rimanga troppo poca per raggiungere la vostra meta.

Tutte considerazioni normalissime: calcolare con precisione il percorso da seguire vi farà raggiungere più rapidamente il vostro obiettivo. Solo che poi guardate più da vicino la bussola che state e usando e vi accorgete che la calamita si è svitata un po’ rispetto alla base, il che vuol dire che adesso l’ago potrebbe puntare in una direzione completamente diversa rispetto al Nord: non sapete quanti giri o parti di giro possa aver fatto.

Questa scoperta vi fa perdere tutta la sicurezza che avevate nel vostro ragionamento di prima, che si basava sul guardare con precisione in quale direzione stava puntando l’ago. Questo è un esempio di considerazione cruciale in ambito escursionistico. L’idea è che ci potrebbero essere considerazioni simili da fare in contesti più importanti e che queste potrebbero mandarci completamente fuori strada. Una considerazione cruciale è un elemento che, se preso in considerazione, stravolgerebbe del tutto le conclusioni a cui altrimenti giungeremmo su come dirigere i nostri sforzi. Può essere anche un’idea o un argomentazione che potrebbe mettere in luce la necessità di rivedere non un piccolo aspetto di un nostro progetto, ma una parte così consistente da richiedere un cambio di direzione o di priorità.

In un contesto utilitarista, si potrebbe descrivere così: una considerazione cruciale è la considerazione di qualcosa che cambia radicalmente il valore atteso nel perseguimento di un sotto-obiettivo di alto livello. L’idea è che avete degli standard di valutazione fissi e che pensiate a un qualche tipo di piano generale per raggiungere un sotto-obiettivo di alto livello. È così che pensate di massimizzare questo standard valutativo. Una considerazione cruciale sarebbe quindi la considerazione di qualcosa che cambia radicalmente il valore atteso del raggiungimento di questo sotto-obiettivo. Più tardi ne vedremo alcuni esempi. Ora, se non vi limitate a un punto di vista utilitarista, potreste voler ritornare a queste prime formulazioni informali, perché una delle idee che si potrebbe mettere in dubbio è proprio l’utilitarismo stesso. Ma per il resto di questo discorso ci concentreremo principalmente su questa componente.

Ci sono altri concetti strettamente collegati che è utile conoscere. La componente di una considerazione cruciale è un’argomentazione, un’idea o un dato che da solo non costituisce una considerazione cruciale, ma che può svolgere, con una probabilità piuttosto alta, un ruolo centrale all’interno di una considerazione cruciale. È il genere di situazione in cui diremmo, “sembra molto interessante, potrebbe essere importante, ma ora come ora non so cosa farmene”. Da solo forse non ci dice nulla, ma forse c’è un altro pezzo che, se messo assieme, potrebbe in qualche modo portarci a qualcosa di importante. Motivo per cui potrebbe essere utile individuare questo genere di componenti di una considerazione cruciale.

C’è poi il concetto di scala delle considerazioni, ovvero una serie di considerazioni cruciali che riguardano lo stesso obiettivo secondario di alto livello e che puntano in direzioni opposte. Qualche esempio di questo tipo di scale di considerazioni cruciali ci aiuterà a comprendere meglio il dilemma.

Dovrei andare a votare?

Pensiamo ad esempio a un classico dilemma: “dovrei andare a votare”? A un “livello base”, diciamo, magari pensereste, “Sì, devo andare a votare in modo che venga eletto un candidato migliore”. Ovviamente ha il suo senso.

Ma poi ci pensate un po’ su: “È molto difficile che il mio voto possa servire a qualcosa. Dovrei usare il mio tempo per qualcosa di più utile che andare a votare.”

(Sono solo esempi per spiegare il concetto in generale. Sono ovviamente complicati e non mi interessa discutere nel dettaglio ora, ma penso che possano essere utili per descrivere il fenomeno in generale.)

Quindi siamo passati da “Sì, dovremmo andare a votare”, prendersi del tempo per andare al seggio, ecc., a “No, non dovrei andare a votare, dovrei fare qualcosa di totalmente diverso” con la considerazione numero due.

A questo punto pensate, “D’accordo, magari non è molto probabile che il mio voto possa servire a qualcosa, ma la posta in gioco è alta: milioni di vite dipendono da questa elezione. Per cui, anche se c’è una possibilità su svariati milioni che il mio voto possa essere decisivo, i possibili vantaggi sono comunque così grandi da meritare di fare un salto al seggio elettorale.” Ero già pronto a rimettermi di fronte alla televisione e guardare la partita, ma ora viene fuori che dovrei andare a votare. La direzione si è ribaltata.

E intanto continuate a pensare. “Beh, ma a meno che non ci sia un testa a testa il mio voto non servirà a nulla. E anche se ci fosse, quasi la metà dei voti andranno al candidato sbagliato, il che vuol dire che o i due candidati sono uguali o quasi, e quindi non importa chi vince, oppure che l’elettore medio è del tutto inaffidabile quando si tratta di giudicare i meriti dei candidati, quindi non c’è modo di raccapezzarsi tra i due e non dovrei perdere tempo a votare.”

Perciò vi rimettete comodi sul divano, tirate fuori i popcorn o quel che vi pare e all’improvviso pensate, “Beh, ma io ovviamente sono in grado di giudicare i candidati meglio di quanto non lo sia l’elettore medio, quindi dovrei andare a votare.”

E poi pensate, “Sì, ma gli ultimi studi di psicologia mostrano che le persone hanno troppa fiducia in se stesse, quasi tutti pensano di essere sopra la media, ma in realtà la possibilità che si sbaglino o abbiano ragione è la stessa. Se ho la stessa probabilità dell’elettore medio di votare per il candidato sbagliato, allora il mio voto avrà un peso pressoché nullo nel processo di selezione, quindi non dovrei andare a votare.”

E sulla stessa scia…

“Va bene, ma se ho perso tempo con tutti questi ragionamenti, allora vuol dire che sono speciale, quindi dovrei andare a votare.”

Ma, “se sono così speciale, allora il costo dell’opportunità…” (Ecco perché vi ho messi in guardia dal diventare filosofi.)

Quindi dovrei fare qualcosa di più importante, ma se non voto i miei amici vedranno che non ho dato il mio sostegno al candidato che sappiamo tutti essere il migliore, penseranno che sono strano, strampalato, che non sono leale, questo potrebbe ridurre l’influenza che ho sulle altre persone e che avrei potuto usare per scopi nobili, quindi dopotutto dovrei andare a votare.

Ma è anche importante far valere le proprie convinzioni, per dare vita a dibattiti stimolanti. Se spiego tutti questi ragionamenti complicati sul fatto di andare a votare i miei amici potrebbero pensare che sono un tipo molto sofisticato, cosa che potrebbe accrescere la mia influenza, che potrei a quel punto sfruttare per fare del bene. Eccetera, eccetera, eccetera.

Non c’è nessun motivo per cui la scala si debba interrompere qui, è solo che a quel punto non abbiamo più energie. Se poi vi fermate a un certo punto, potreste chiedervi: e se ci fossero ancora altri scalini su questa scala? Quanto valide pensate che siano le conclusioni a cui siete arrivati in questa fase, in questo momento?

Dovremmo privilegiare i fondi per la ricerca sui rischi esistenziali?

Ecco un altro esempio di scala di considerazioni, questa volta nel contesto delle politiche sulla tecnologia e i rischi esistenziali. È il genere di ragionamento che si potrebbe fare per alcuni tipi di tecnologia, a prescindere dal fatto che stiamo cercando di promuoverli o di ottenere più finanziamenti.

La tecnologia in questione sono le nanotecnologie. Si tratta in effetti dell’esempio da cui ha avuto origine questo tipo di ragionamento. Alcune parti fanno riferimento addirittura a Engines of Creation di Eric Drexler, in cui sostiene questa linea di pensiero (capitolo 12). Al “livello base” del ragionamento, dovremmo finanziare la ricerca sulle nanotecnologie perché in futuro avranno molti usi possibili, dalla medicina all’industria e all’energia sostenibile, ecc. Godere di tutti quei benefici sarebbe fantastico.

Ma c’è anche il fatto che le nanotecnologie potrebbero avere applicazioni importanti in campo militare, potrebbero essere utilizzate da gruppi terroristici o altri per creare nuove armi di distruzione di massa che potrebbero costituire una minaccia esistenziale rilevante. Se sono così pericolose, allora forse non dovremmo finanziarne la ricerca.

Ma se è possibile sviluppare questo tipo di tecnologia, allora prima o poi verrà quasi sicuramente sviluppato, che noi decidiamo di investirci o meno. (“Noi” inteso come forse le persone in questa stanza o quelle nel Regno Unito o nelle democrazie occidentali.) Se le persone con senso critico si astengono dallo sviluppare questa tecnologia, allora verrà sviluppata da persone irrazionali, cosa che accrescerebbe ancora di più i rischi, quindi dovremmo finanziarne la ricerca.

(Si capisce subito come lo stesso schema potrebbe essere utile per valutare altre tecnologie con pro e contro, oltre alle nanotecnologie.)

Ma le stiamo già sviluppando, quindi finanziamenti extra non farebbero altro che portarci a quel punto più in fretta, senza lasciarci il tempo di prepararci per eventuali pericoli. Per questo non dovremmo aggiungere ulteriori finanziamenti: le persone responsabili possono arrivarci per prime anche senza aggiungere ulteriori finanziamenti per questa impresa.

Poi però vi guardate attorno e vi rendete conto che quasi nessuno sta facendo nulla per prepararsi agli eventuali pericoli delle nanotecnologie (l’assunto principale di Drexler in Engines), perché qualsiasi tipo di preparazione un minimo seria comincerebbe solo dopo che è già partito un progetto su larga scala per sviluppare le nanotecnologie. Solo a quel punto le persone prenderebbero l’ipotesi sul serio.

Prima comincia un progetto tipo Progetto Manhattan per sviluppare nanotecnologie e più tempo servirà per completarlo, perché prima si comincia e meno solide sono le basi su cui ci si appoggia. Il lavoro sul progetto vero e proprio durerebbe ancora più a lungo, il che significherebbe altro tempo speso nei preparativi: i preparativi veri e propri cominciano solo quando comincia il progetto, prima comincia il progetto e più tempo ci vorrà per completarlo, per cui il tempo di preparazione sarà più lungo. Dal che se ne deduce che dovremmo fare pressione perché questo prodotto venga distribuito immediatamente per massimizzare il tempo necessario ai preparativi.

Ma ci sono altri fattori da tenere in considerazione. Il livello di rischio è influenzato da altri fattori oltre alla quantità di preparativi seri che vengono fatti, soprattutto quando si parla di contrastare eventuali minacce delle nanotecnologie. Ad esempio, macchine senzienti o sistemi di sorveglianza onnipresenti potrebbero essere sviluppati prima delle nanotecnologie, di fatto eliminando o riducendo i rischi di quest’ultime. Queste altre tecnologie comportano a loro volta dei grandi rischi, ma sono rischi che dovremmo comunque affrontare. C’è molto altro da dire sull’argomento.

Le nanotecnologie non ridurrebbero davvero questi rischi, come i rischi derivanti dalle intelligenze artificiali. Idealmente sarebbe preferibile arrivare ad avere superintelligenza o una sorveglianza totale prima delle nanotecnologie e dovremmo opporci a ulteriori finanziamenti per le nanotecnologie anche se la superintelligenza e una sorveglianza totale portassero con loro altri rischi, inclusi quelli esistenziali, considerando alcune ipotesi fatte a proposito della teoria sul completamento tecnologico — secondo la quale in un arco di tempo abbastanza lungo, a meno che la civiltà non collassi, ogni possibile tecnologia utile verrà prima o poi sviluppata – dovremo prima o poi affrontare questi pericoli e l’unica scelta che abbiamo è l’ordine in cui affrontarli. Ed è meglio affrontare la superintelligenza prima delle nanotecnologie perché la superintelligenza può risolvere i problemi delle nanotecnologie, ma non viceversa.

Tuttavia, se qualcuno si oppone a finanziamenti extra per le nanotecnologie, allora quelli che lavorano alle nanotecnologie detesteranno quelli che vi si oppongono. (Un’altra considerazione del libro di Drexler.) Ma altri scienziati potrebbero vedere queste persone che si oppongono alle nanotecnologie come se si opponessero alla scienza in generale e questo ridurrebbe la nostra capacità di lavorare con questi scienziati, ostacolando il nostro lavoro su problemi specifici di conseguenza – lavoro che ha più probabilità di fare la differenza per qualsiasi tentativo di influenzare i livelli di finanziamenti nazionali per le nanotecnologie. Quindi non dovremmo opporci alle nanotecnologie. Vale a dire che, piuttosto che opporci alle nanotecnologie – forse potremmo rallentarne lo sviluppo, ma siamo un gruppo ridotto e non faremmo questa grande differenza – dovremmo invece lavorare assieme agli scienziati che si occupano di nanotecnologie, essere loro amici e poi magari cercare di influenzarli un po’ in modo che sviluppino le nanotecnologie in maniera leggermente diversa o con maggiori sistemi di sicurezza e cose simili.

Di nuovo, non abbiamo nessun motivo per pensare di aver raggiunto il livello massimo di considerazione su questo argomento. È sconvolgente, perché sembra quasi che il risultato definitivo oscilli da una parte e dell’altra man mano che ci addentriamo nella ricerca. Potrebbe venire da chiederci come mai. Ho idea che queste scale di considerazione compaiano più spesso quando cerchiamo di essere utilitaristi al 100% e cerchiamo davvero di avere una visione d’insieme.

Considerazioni cruciali e utilitarismo

Vediamo alcuni motivi plausibili per questo fenomeno. Se ad esempio confrontiamo il campo di applicazione dell’utilitarismo con un altro campo di applicazione, diciamo una normale funzione umana preferita – una vita soddisfacente, una famiglia in salute, una carriera di successo e un po’ di relax, tipici valori umani – se cerchiamo di soddisfare questi valori, non sembra molto probabile che incontreremo un gran numero di considerazioni cruciali. Come mai?

Una possibile spiegazione è che abbiamo più conoscenza ed esperienza a livello personale della vita umana. Miliardi di persone hanno cercato di massimizzare una normale funzione d’utilità umana, hanno ricevuto un sacco di feedback e hanno provato un sacco di cose. Per cui abbiamo già un’idea delle basi, se vogliamo andare avanti per decenni è meglio se mangiamo, cose del genere.

Non si tratta di cose che dobbiamo scoprire. Forse sono le nostre stesse preferenze che sono state modellate dall’evoluzione sulla base del tipo di opportunità che possiamo sfruttare in natura a livello cognitivo. Potremmo quindi non avere qualche bizzarra preferenza che non avremmo in alcun modo potuto soddisfare. Al contrario, nell’ottica utilitarista, la preferenza utilitarista va molto al di là del territorio familiare per includere il cosmo, i miliardi di anni di futuro davanti a noi e civiltà super-avanzate: in un’ottica utilitarista, ciò che fanno è importante e parecchio. La maggior parte delle cose che importano per una preferenza utilitarista sono cose con cui non abbiamo alcuna familiarità.

Un’altra possibile fonte di considerazioni cruciali riguardo all’utilitarismo sono le difficoltà nel cercare di comprendere l’obiettivo stesso. Ad esempio, se proviamo a pensare a come applicare l’utilitarismo in un mondo che ha probabilità finite di essere infinito, ci scontreremo con alcune difficoltà quando si tratterà di misurare diverse grandezze infinite e allo stesso tempo cercare di capire come possiamo avere un qualunque impatto sul mondo. Io personalmente ho pubblicato un saggio lunghissimo a questo proposito e non c’è bisogno che lo guardiamo adesso. Ci sono poi altri problemi, che consistono nel cercare davvero di modellare l’utilitarismo in modo da poterlo applicare a tutti questi possibili casi.

La terza spiegazione possibile è che potremmo pensare di essere più o meno vicini, non stra-vicini, ma vicini a un qualche momento fondamentale della storia umana, il che significa che in questo momento potremmo avere opportunità speciali per influenzare il futuro sul lungo periodo. E siamo ancora ben lontani dal farlo: non sappiamo ancora cosa dovremmo fare di preciso per avere il maggior impatto positivo possibile sul futuro. Ma siamo abbastanza vicini da poter magari cominciare a intravedere il profilo di quella cosa che modellerà il futuro. Ad esempio, potreste pensare che la superintelligenza sia un momento fondamentale, o uno di quelli (alcuni di questi momenti fondamentali potrebbero essere rischi esistenziali) che affronteremo nel corso di questo secolo. In tal caso, può essere che abbiamo appena cominciato ad acquisire le capacità per pensare a quelle cose, il che ci porta a un’altra serie di considerazioni che potrebbero essere molto importanti.

Potrebbero esserci ripercussioni anche nella nostra sfera personale. Esattamente come con la funzione d’utilità tipica di una persona normale: con ogni probabilità, per questa persona vivere un miliardo di anni non ha un valore un milione di volte superiore rispetto a vivere per cento anni, così come crescere mille bambini non ha un valore mille volte superiore rispetto al crescerne uno solo. Per cui, anche se il futuro esiste ancora, non ha lo stesso peso all’interno di una funzione d’utilità umana che ha per l’utilitarismo.

Infine, un’altra considerazione è che abbiamo scoperto di recente alcuni strumenti esplorativi fondamentali che ci consentono di fare queste scoperte importantissime su come essere buoni utilitaristi. E questi strumenti non ci hanno ancora dato tutto quello che ci possono offrire, per cui continuiamo a scoprire sempre nuove cose importanti. Ecco perché ci sembra di scoprire sempre così tante considerazioni cruciali. Potremmo parlarne un po’ più avanti nella presentazione.

Funzioni di valutazione

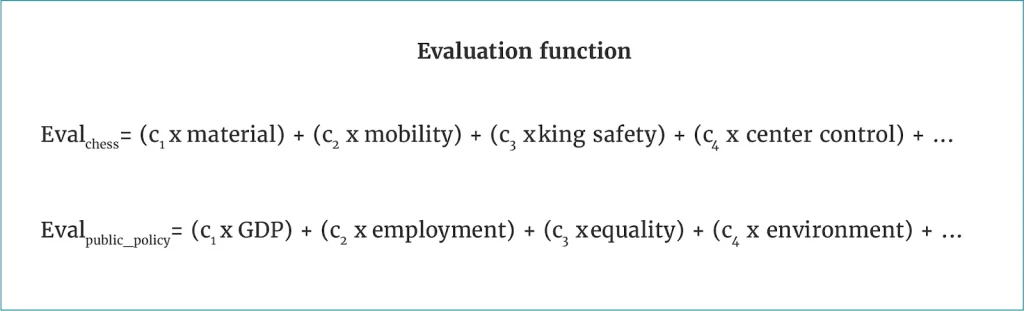

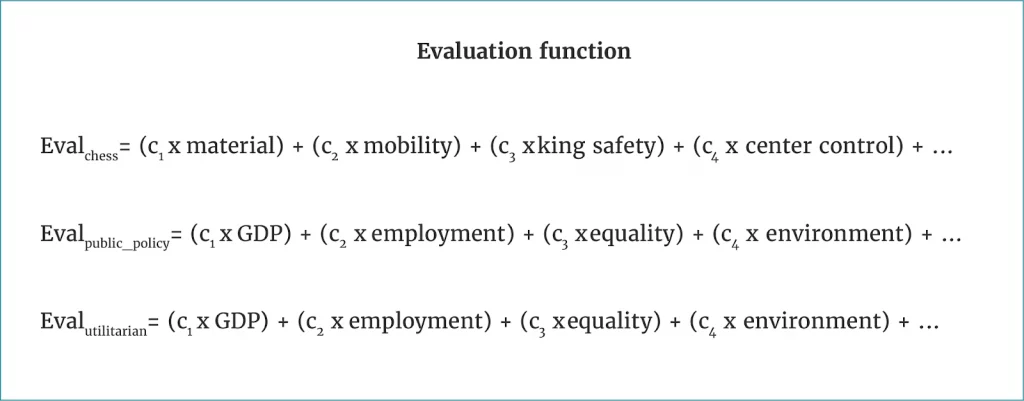

Ora permettetemi di analizzare la questione da una prospettiva leggermente diversa. Quando si gioca a scacchi la strategia ideale consiste nel pensare alle possibili mosse che si possono fare, poi alle possibili contromosse dell’avversario e poi alle contromosse a quelle contromosse. In una situazione ideale ragionereste in questo modo fino all’ipotetica fine della partita e poi semplicemente selezionereste la mossa iniziale migliore per vincere quando siete in grado di calcolare tutte le mosse possibili. Ma calcoli del genere sono impossibili da fare, perché le possibilità sono troppe: bisognerebbe tenere in considerazione un numero esponenziale di mosse possibili.

Quello che bisogna fare invece è calcolare in anticipo un certo numero di mosse. Dodici mosse in anticipo o qualcosa del genere. La vostra analisi termina qui. Quello che dovete avere a questo punto è una funzione di valutazione relativamente semplice da creare, che sia in grado di visualizzare lo stato possibile della scacchiera dopo una sequenza di sei mosse e contromosse e di calcolare alla buona quanto è desiderabile quello stato. Una classica funzione di valutazione di una partita a scacchi assomiglia a una cosa di questo tipo.

C’è un termine che valuta quanto materiale abbiamo a disposizione, ad esempio è un vantaggio avere la regina e un sacco di pedine. È anche un vantaggio se l’avversario di pedine ne ha poche. Ci sono alcune metriche che ci dicono che un pedone vale uno e la regina vale, non so, 11 o qualcosa del genere.

A questo punto fate i vostri conti, una componente chiave della funzione di valutazione. Poi magari considerate quanto possono muoversi i vostri pezzi. Se sono tutti intrappolati in un angolo, quella di solito è una situazione grama, quindi bisogna assegnargli un termine. La sicurezza del re e il controllo del centro aggiungono un po’ di valore: se controllate il centro della scacchiera, sappiamo per esperienza che tende a essere una buona posizione.

A questo punto calcolate un certo numero di mosse in anticipo e come risultato avete questa funzione di valutazione relativamente stabile che usate per capire quale delle aperture a vostra disposizione vi condurrà alla situazione più vantaggiosa. Questo tipo di funzioni di valutazione derivano principalmente dalle partite di alcuni maestri di scacchi che hanno un sacco di esperienza nel giocare. I parametri, come il peso da dare a ogni dato, possono anche essere appresi da un’intelligenza artificiale.

Qualcosa di simile lo facciamo in altri campi. Come una politica amministrativa tradizionale, gli economisti del welfare potrebbero pensare che è necessario massimizzare una qualche funzione del welfare che potrebbe avere un aspetto di questo tipo.

PIL? Sì, vogliamo più PIL, ma dobbiamo anche tenere in considerazione la percentuale di disoccupazione, forse la percentuale di equità e disuguaglianza, alcuni fattori sullo stato dell’ambiente. Forse ciò che inseriamo in quei campi non è l’equivalente preciso della bontà morale nella sua interezza, ma sappiamo che queste cose di solito sono positive, o almeno così pensiamo.

Questa è una buona approssimazione del valore reale che potrebbe essere più gestibile in un contesto decisionale. A questo punto possiamo chiederci se esiste qualcosa di simile per la bontà morale. Vogliamo fare il meglio dal punto di vista morale, ma sembra molto difficile o impossibile riuscire a calcolare da zero tutte queste variabili in qualsiasi situazione. Abbiamo bisogno di principi più stabili con cui valutare le diverse cose che potremmo fare. In questo caso potremmo avere di fronte versioni più ristrette dell’utilitarismo. Cosa potremmo inserire in questi campi?

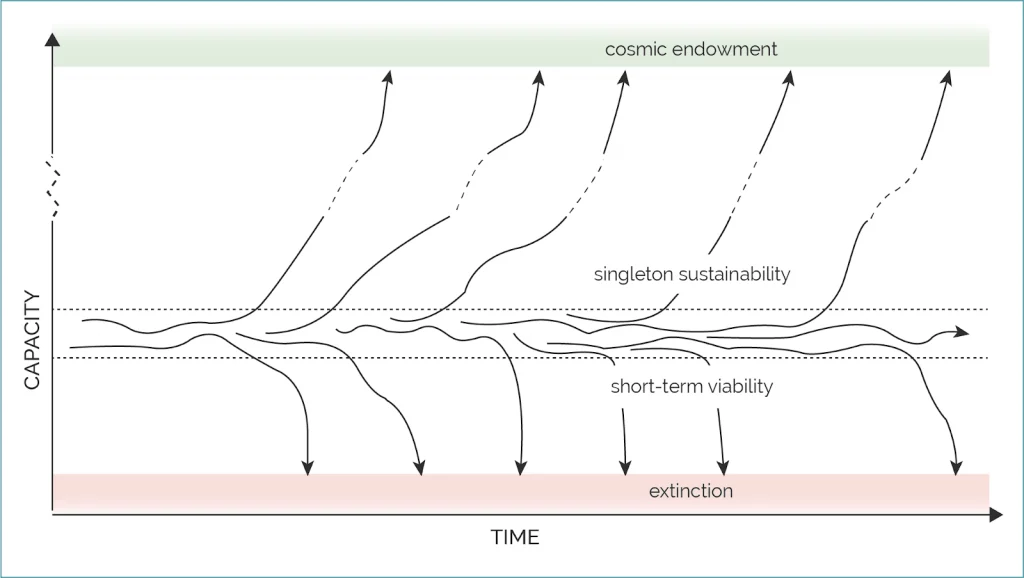

In questo caso possiamo fare riferimento ad alcune delle cose di cui ha parlato Beckstead. Se inseriamo la capacità, che potrebbe essere il livello di sviluppo economico e complessità tecnologica, cose del genere, su un asse e il tempo su un altro, la mia opinione è che la condizione umana è una sorta di regione metastabile sull’asse della capacità.

Potrebbero esserci leggere fluttuazioni al suo interno, ma maggiore è la scala temporale presa in considerazione, maggiori sono le possibilità di uscire da quella regione o con una tendenza decrescente ed estinguersi – se ci sono troppe poche risorse rispetto alle dimensioni minime possibili di una data popolazione, allora ci si estingue (uno stato d’inerzia: una volta estinti, di solito si rimane estinti) – o con una tendenza a crescere: raggiungiamo la maturità tecnologica, cominciamo un’opera di colonizzazione e il futuro della vita intelligente originaria della Terra potrebbe quindi essere questa bolla che si espande con una velocità che è una frazione rilevante della velocità della luce e finisce per avere accesso a tutte le risorse dell’universo che, in linea di principio, sono accessibili dal nostro punto di partenza. Si tratta di una quantità finita per via della costante cosmologica positiva: è pressoché certo che abbiamo a disposizione solo una quantità finita di cose. Ma una volta che il processo è avviato, una volta che siamo un impero intergalattico, sembra molto probabile che si possa andare avanti verso questa visione naturale.

Il concetto di rischio esistenziale può essere definito come qualcosa che non permette di accedere al potenziale di valore che si potrebbe guadagnare avendo accesso ai beni cosmologici, o perché ci si estingue o perché magari si accede a tutti i beni cosmologici, ma non si riesce a usarli per scopi benefici o qualcosa del genere.

Questo implica il principio di Maxipok di cui parlava anche Beckstead: Massimizzare le probabilità di un risultato positivo. Ovviamente questa è al massimo una regola generale: non deve essere presa come un principio morale valido in tutte le situazioni possibili. Non lo è. Anzi, se volete distanziarvi dal principio originale con cui avete cominciato per spostarvi verso qualcosa di più gestibile nella pratica, dovete fare in modo che sia subordinato a diversi assunti empirici. Questo è il compromesso necessario: formulare assunti più deboli possibile e riuscire comunque a renderli il più gestibili possibile.

Penso si tratti di un compromesso ragionevole. Detto altrimenti, agite in modo da minimizzare l’integrale del rischio esistenziale che l’umanità dovrà affrontare. Non sempre otterrete la risposta giusta, ma è un inizio. Ci sono cose diverse rispetto a quelle menzionate da Beckstead, altri scenari possibili in cui tutto questo vi darebbe una risposta errata: se pensate che ci possa essere un alto rischio di iper-catastrofe esistenziale, un qualche scenario infernale, allora può essere utile aumentare leggermente il livello di rischi esistenziali per far diminuire il rischio che ci sia non solo una catastrofe esistenziale, ma una iper-catastrofe esistenziale. Altre possibili interferenze sono cambi di traiettoria, meno drastici e che comportano cambiamenti minimi.

In questo momento possiamo semplicemente prendere in considerazione l’ipotesi di usare la regola di Maxipok per cercare di definire la funzione di valore degli agenti utilitaristi. La domanda quindi diventa, “Se volete minimizzare il rischio esistenziale, cosa dovete fare?” Si tratta ancora di un obiettivo di livello molto alto, che richiede comunque molto lavoro per essere analizzato nelle sue componenti più concrete.

Non sono sicuro che questo c’entri molto con il resto della presentazione.

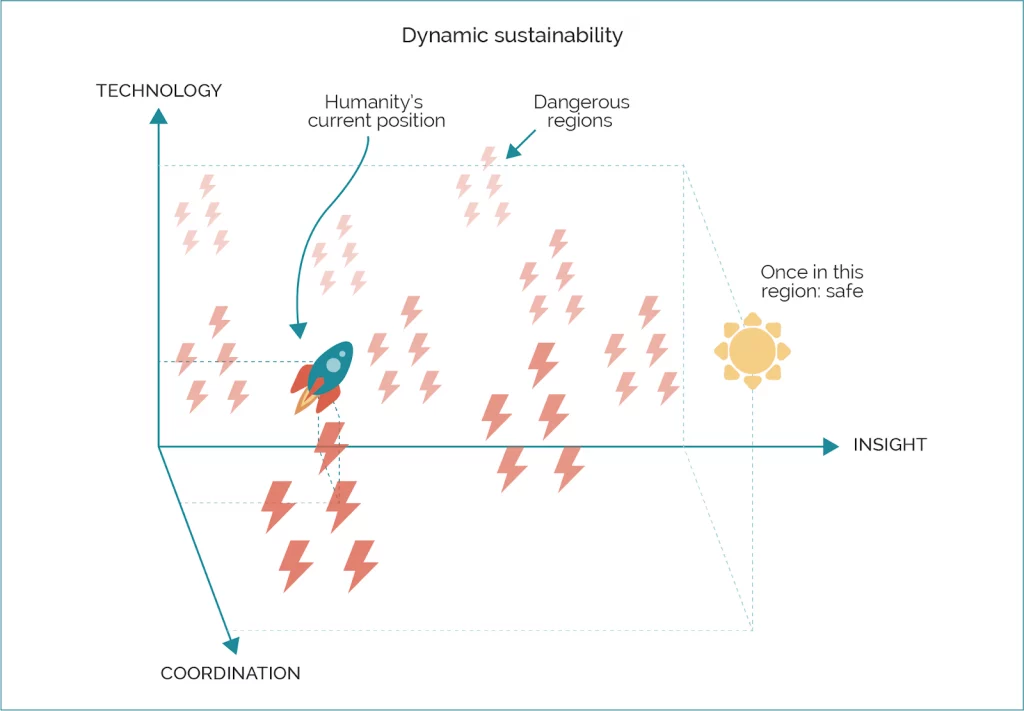

Questa bella slide la tenevo per un’altra presentazione. Si tratta di un modo diverso di dire quello che ho già detto: invece di pensare alla sostenibilità come si fa di solito, come un concetto statico in uno stato d’inerzia che dovremmo cercare di stimare in qualche modo, in cui non usiamo più risorse di quelle che sono disponibili nell’ambiente naturale, penso che dovremmo pensare alla sostenibilità in termini dinamici, in cui, invece di raggiungere uno stato, cerchiamo di raggiungere e rimanere su una traiettoria che è sostenibile per un tempo indefinito, nel senso che possiamo mantenerlo tale per viaggiare su quella traiettoria per un tempo indefinito e ci porta nella direzione giusta.

Un’analogia utile in questo caso è quella del razzo. Uno degli stati d’inerzia di un razzo è quando si trova sulla pista di lancio: ci può rimanere per molto tempo. Un altro stato d’inerzia è quello in cui si trova quando è nello spazio, può continuare a viaggiare per ancora più tempo, forse, se non arrugginisce o cose simili. Ma in fase di lancio è in uno stato d’instabilità. Ecco a che punto è l’umanità secondo me: in fase di lancio. Il concetto di sostenibilità statica implica che dovremmo ridurre al minimo i nostri consumi di combustibili fossili che ci permettono di rimanere in aria. In questo modo forse prolunghiamo il tempo in cui possiamo rimanere nella situazione attuale, ma può darsi che quello che dobbiamo fare è massimizzare il consumo di combustibile in modo da guadagnare abbastanza spinta per raggiungere la velocità di fuga. (Attenzione, perché non si tratta di un’argomentazione a favore del consumare più combustibile fossile possibile. È solo una metafora.)

Il punto è che per ottenere le migliori condizioni possibili dobbiamo disporre di tecnologia super-avanzata: per poter accedere ai beni cosmici, per poter curare tutte le malattie che ci affliggono, ecc. Penso che, per poter costruire il migliore dei mondi possibili, quello che ci occorre è anche una quantità immensa di saggezza e conoscenza profonda e una grande capacità di coordinarsi per evitare di utilizzare questa tecnologia raffinata per farci la guerra l’un l’altro e così via. Alla fine della fiera, quello di cui abbiamo bisogno è uno stato in cui abbiamo grandi quantità di ognuna di queste tre variabili, ma c’è ancora da risolvere un altro problema, vale a dire cosa vogliamo di più dalla nostra considerazione. Potremmo magari volere maggiore coordinazione e conoscenza prima di avere più tecnologia di un certo tipo, quindi prima di avere diverse tecnologie all’avanguardia sarebbe bene assicurarsi di avere abbastanza pace e comprensione per non usarle in guerra, oltre alla conoscenza e alla saggezza necessarie per evitare di farci saltare in aria per sbaglio.

Ovviamente una superintelligenza sembra proprio quello che ci vorrebbe in un’utopia – è un tipo di tecnologia ad altissimo livello –, ma prima di svilupparla sarebbe meglio avere un certo livello di conoscenza profonda, per assicurarci di svilupparla nel modo corretto.

In analogia con il test del computer, potremmo chiederci se ci siano alcune caratteristiche che potrebbero essere usate come componenti per questa funzione di valutazione dell’utilitaristico, il Maxipok.

Il principio dello sviluppo tecnologico differenziale implica che dovremmo rallentare lo sviluppo di tecnologie pericolose e dannose – vale a dire, tecnologie che aumentano il rischio esistenziale – e accelerare quello di tecnologie che riducono il rischio esistenziale.

Non si tratta di una risposta definitiva, è solo una bozza, ma la conclusione potrebbe essere che sarà necessaria molta saggezza, molta pace internazionale e cooperazione, mentre per quel che riguarda la tecnologia le cose sono un po’ più complicate: progressi più rapidi in alcuni campi, forse, e meno rapidi in altri. Penso che in linea generale siano questi i tre tipi di cose che si potrebbero inserire in una funzione di valutazione.

Il che implica che una cosa a cui pensare, oltre agli interventi o le cause, è il peso dei diversi tipi di cose. Un intervento dovrebbe avere all’incirca un grande impatto e un’area di intervento dovrebbe offrire interventi ad alto impatto. Non è sufficiente che quello che fate faccia del bene, è necessario pensare a fondo a quanto bene si può fare in relazione ad altre cose di cui potreste occuparvi. È inutile pensare alle cause senza pensare a tutti gli ambiti d’intervento facili a cui si potrebbe accedere. Molte delle riflessioni vanno fatte in questo ambito.

Ma quando ci muoviamo su questo livello più elevato, quest’altezza a cui si trovano queste considerazioni cruciali, allora sembra che anche pensare a come definire le caratteristiche dei diversi parametri di base abbia un suo valore, forse anche quando non siamo sicuri dell’influenza che potrebbe avere su di essi. (Detto in parole povere, la caratteristica è essenzialmente “Ne vogliamo di più o di meno?”). All’inizio potremmo raggruppare queste domande in base all’impatto, perché per orientarci in questo ambito, all’inizio, potrebbe essere utile rimandare la domanda a più avanti, almeno per un po’. Ma un buon indicatore – cioè un buon parametro di cui vorremmo definire il tratto distintivo – dovrebbe essere individuabile da lontano. Vale a dire che, se definiamo una quantità in termini che ci rendono molto difficile stabilire se un qualsiasi intervento contribuisce in modo positivo o negativo alla quantità che abbiamo appena definito, allora non è un indicatore utile. Quindi “massimizzare il valore atteso”, diciamo, è la quantità che questi potrebbero definire. Solo che non ci aiuta granché, perché quando proviamo a fare qualcosa di specifico quasi non ci muoviamo da dove abbiamo cominciato. D’altro canto, se ci poniamo un obiettivo più concreto, come massimizzare il numero di persone in questa stanza o qualcosa del genere, capiamo con facilità quante persone ci sono e come potremmo massimizzarne il numero. Perciò, per ogni azione che ci viene in mente, possiamo vedere con facilità l’effetto che avrebbe nel cercare di massimizzare il numero di persone in questa stanza. In compenso potrebbe essere molto difficile trovare buone ragioni per affermare che avere più persone nella stanza sia meglio o se possa esserci un rapporto inverso. Un buon indicatore deve trovare un buon compromesso tra l’essere identificabile da lontano e solido al punto da poter fare affidamento sulle sue caratteristiche.

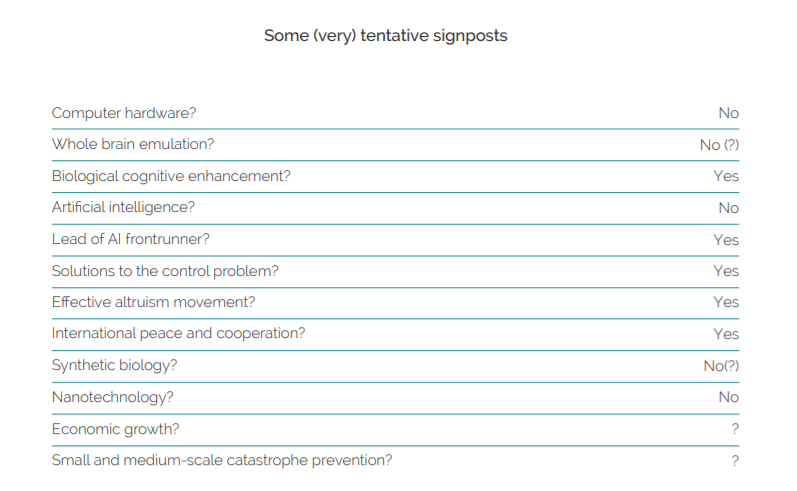

Indicatori provvisori

Ecco alcuni indicatori molto provvisori: sono provvisori dal mio punto di vista e immagino che molte persone potrebbero non essere d’accordo. Questi sono più che altro campi d’indagine, ma possono essere utili per illustrare il modo in cui si può pensare in questo ambito.

Quando si parla di hardware sono meglio progressi più rapidi o più lenti? La stima migliore che posso fare è che sono meglio progressi più lenti e questo per via dei rischi legati alla transizione verso le intelligenze artificiali. Con computer più veloci sarebbe più facile creare IA, cosa che (a) probabilmente ne accelererebbe lo sviluppo, cosa che sembra forse in se stesso perché ci lascia meno tempo per prepararci in modo adeguato, cosa di cui abbiamo un gran bisogno; e (b) potrebbe abbassare il livello di competenza necessario per sviluppare IA: con una potenza di calcolo assurdamente grande potremmo sviluppare IA senza sapere davvero granché di quello che stiamo facendo; quando siamo limitati dall’hardware abbiamo bisogno di più conoscenze e competenze e, se le IA sono create da gente con maggiori conoscenze e competenze, meglio è.

Ovviamente non intendo scartare a prescindere quest’idea, perché ci sono altri rischi esistenziali. Se vi è mai venuto in mente che potremmo estinguerci nel prossimo futuro perché qualcuno svilupperà un qualche tipo di nanotecnologia, forse è il caso che diate un’occhiata alle mine vaganti nel campo delle IA il prima possibile. Ma tutto considerato questa è la stima migliore che riesco a fare al momento. Un tipo di ragionamento condivisibile.

Emulazione completa del cervello? Abbiamo compilato una lunga, lunga analisi sull’argomento. Più nello specifico, non se sia un bene arrivare a un’emulazione completa del cervello, ma se sia meglio allocare più o meno fondi all’emulazione completa del cervello, più o meno risorse per svilupparla. È una possibile strada verso la superintelligenza artificiale e, per ragioni piuttosto complicate, la mia risposta è “No”, ma in questo caso ci sono ancora più dubbi e all’interno del nostro gruppo di ricerca ci sono molti punti di vista diversi. (Se qualcuno è interessato a un punto di vista in particolare, ne possiamo parlare nella fase di domande e risposte.)

Miglioramento cognitivo biologico? La mia opinione è che sarebbe meglio fare progressi più rapidi in questo campo.

Quindi con queste tre – ne parlo più nel dettaglio nel libro — e anche con le IA.

IA Penso sia meglio se lo sviluppo delle IA proceda un po’ più lentamente di quanto non farebbe naturalmente.

Un’altra domanda:

Se ci fosse una società o un progetto o una squadra che sviluppasse la prima intelligenza artificiale di successo, sarebbe meglio che quella squadra avesse del vantaggio rispetto a un’altra che ci sta provando, ma quanto vantaggio? Per quel che mi riguarda, sarebbe meglio se avesse molto vantaggio, molti anni, di modo da poter rallentare verso la fine del progetto per poter implementare ulteriori misure di sicurezza e non essere costretti a fare in fretta per battere le altre aziende.

Soluzioni al problema dell’allineamento delle IA? Penso sia meglio fare progressi più rapidi. È uno dei nostri ambiti di ricerca e alcuni dei nostri amici del Machine Intelligence Research Institute qui presenti ci stanno lavorando sodo.

La comunità dell’altruismo efficace? Penso che per molte ragioni davvero importanti sia meglio avere una crescita rapida e solida in quest’ambito.

Pace e cooperazione internazionale? Ottimo.

Biologia di sintesi? Non la vedo bene. Non ci abbiamo pensato con sufficiente attenzione, potrebbe cambiare in futuro, ma penso che potrebbe portare a diversi rischi esistenziali, anche se potrebbe anche avere i suoi vantaggi. Per quanto possa portare a progressi nel campo del miglioramento cognitivo, si tratterebbe di un compromesso difficile.

Nanotecnologie? La vedo male. Meglio se i progressi in quest’ambito sono più lenti.

Crescita economica? Difficile dire con precisione quali possano essere le conseguenze, secondo me. E anche all’interno di una comunità che ci ha riflettuto con attenzione ci sono di nuovo molti punti di vista diversi.

Prevenzione di disastri su piccola e media scala? Ottimo. Rischi di catastrofi su scala globale appena un gradino sotto i rischi esistenziali. Di nuovo, molto difficile capire a cosa possa portare. Qui stiamo raggruppando per impatto, anche solo sapere se ne vogliamo di più o di meno, se possiamo averlo gratis, non è immediato. D’altro canto, disastri su piccola scala potrebbero creare una sorta di risposta immunitaria che ci renderà migliori, ci consentirà di adottare misure di sicurezza migliori e cose del genere, che ci potrebbero proteggere da cose peggiori. Quanto ai disastri su media scala che potrebbero portare al collasso della nostra civiltà, larga scala per gli standard comuni, ma solo media scala rispetto alle catastrofi esistenziali, che in questo contesto sono più grandi, di nuovo, è non è facile capire quale sia il tratto distintivo di ciò: c’è ancora molto lavoro da fare per capirlo. Se ci sono buone possibilità di ripresa, allora vale la pena pensare alle possibilità che avrà questa civiltà di evitare una catastrofe esistenziale dopo essere passata attraverso questo disastro.

Questi sono i parametri su cui vale la pena concentrarsi all’inizio. È difficile rendersi conto quanto sia complicato, il buon senso ti dice che alcuni parametri sembrano ovvi, ma si rivelano essere ben poco ovvi quando cominci a riflettere sul modo in cui devono combinarsi.

Immaginate di essere un amministratore qui a Oxford, lavorate nel dipartimento di informatica e avete un segretario. Immaginate di aver trovato un modo per rendere un po’ più efficiente il lavoro in dipartimento: create una mailing list in modo che, quando qualcuno ha un annuncio da fare, lo può inviare alla mailing list invece che a ogni singola persona. È una cosa utile, è fantastica: non è costato nulla tranne un piccolo pagamento una tantum e rende più facile il lavoro di tutti. Da questo punto di vista è molto poco ovvio se si tratta davvero di una buona cosa. Potrebbe contribuire all’IA – potrebbe essere la conseguenza principale, oltre a un effetto generale molto ridotto sulla crescita economica. Può anche darsi che con questa piccola miglioria abbiate peggiorato il mondo per quel che riguarda le aspettative. Da un certo punto di vista questa idea di riflettere a fondo sulle cose è un po’ come il concetto dell’Umwertung aller Werte — la trasvalutazione di tutti i valori— di Nietzsche, un progetto che non ha mai potuto completare prima di perdere la testa.

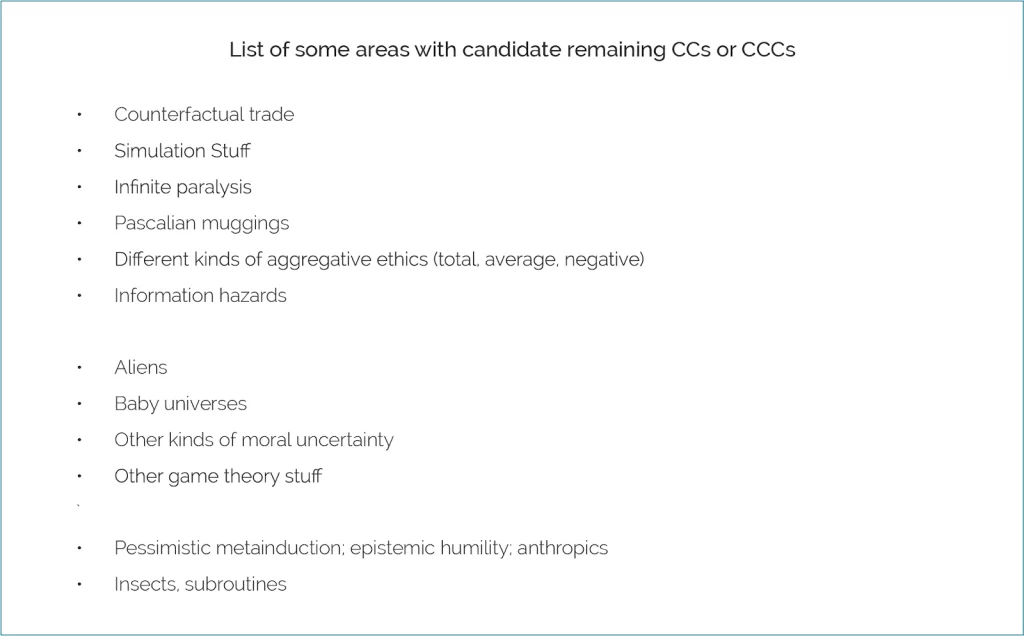

Campi in cui è possibile trovare considerazioni cruciali

Questi sono dei campi – non entrerò nel dettaglio di nessuno di questi, mi servono solo come esempi dei tipi di campi in cui è possibile trovare considerazioni cruciali. Non si tratta affatto di un elenco completo, ne possiamo poi parlare di più dopo. L’ordine è all’incirca dal più generale, astratto e potente al più specifico e comprensibile dal pensiero comune.

Per fare un esempio: gli insetti. Se siete utilitaristi tradizionali, questa considerazione sorge nella vita quotidiana – mettiamo da parte i beni cosmologici e pensiamo alla vita qui sulla Terra. Se gli insetti hanno coscienza di sé, allora si tratta di una coscienza molto grande perché di insetti ce ne sono molti, ma molti. Può darsi quindi che l’effetto delle nostre politiche sul benessere degli insetti sia più grande di quello delle nostre politiche sul benessere umano o degli animali negli allevamenti intensivi e cose del genere. Non sto dicendo che è vero per forza, ma è una domanda per nulla scontata e che potrebbe avere un grande impatto.

Un altro esempio:

Subroutine. In futuro potremmo scoprire che i processi di certi tipi di intelligenza artificiale, come gli algoritmi di apprendimento per rinforzo e altri sottoprocessi all’interno dell’IA, potrebbero avere un qualche tipo di status morale. Questi sottoprocessi potrebbero avere centinaia di migliaia di esecuzioni, per cui, se viene fuori che alcune di queste cose hanno un valore, allora i numeri sarebbero di nuovo dominanti.

Rimedi parziali

Ognuno di questi rimedi richiederebbe un workshop a sé stante e non possiamo vederli nel dettaglio. Ma cosa possiamo fare se pensiamo che possano esserci delle considerazioni cruciali, alcune magari non ancora scoperte? Impossibile rispondere in maniera definitiva. Questi sono alcuni consigli prima facie che potremmo seguire:

- Non siate precipitosi, soprattutto in azioni che sono irreversibili.

- Investite più tempo in analisi per trovare e mettere assieme le considerazioni cruciali mancanti. È il motivo per cui faccio il lavoro che faccio e per cui gli altri tra di noi sono coinvolti in questa impresa.

- Tenete a mente che con ogni probabilità i cambiamenti di valore atteso sono più piccoli di quel che sembrano. Se siete utilitaristi, diciamo che avete sviluppato questo nuovo ragionamento che ha implicazioni profonde su quello che dovreste fare, alla luce di queste nuove informazioni la prima cosa che potrebbe venirvi in mente di fare è di riformulare completamente l’utilità prevista di diverse politiche pratiche. Ma quando riflettete sul fatto che ogni tanto vengono scoperte nuove considerazioni cruciali, forse allora potreste ancora riformulare il valore atteso, ma non tanto quanto avevate pensato di fare all’inizio. Vale la pena rifletterci a un livello superiore.

- Tenete a mente l’incertezza morale fondamentale. Se allarghiamo i nostri orizzonti e non ci limitiamo a considerare solo l’utilitarismo, dato che dovremmo tenere in considerazione anche cose provenienti da un punto di vista normativo in generale meno limitato, allora modelli che tengono in considerazione l’incertezza normativa, come il Modello Parlamentare, sembrano piuttosto solidi. L’idea è che, se non siete sicuri di quale tra le molte teorie morali sia corretta, allora dovreste assegnare a queste teorie una certa probabilità e immaginare un parlamento in cui ogni teoria morale ha un certo numero di rappresentanti in base alla sua probabilità. In questo parlamento immaginario, i rappresentanti delle varie teorie morali discutono, cercano compromessi e prendono decisioni su cosa fare. A questo punto della nostra metafora dovreste fare quello che farebbe questo parlamento morale. L’idea è che, a parità di condizioni, più probabilità ha una teoria morale e maggiore è il suo peso nell’influenzare le vostre azioni, anche se potrebbero esserci delle specie di accordi tra le varie teorie morali, penso che Toby Ord ne abbia parlato nella sua presentazione. Si tratta di una metafora su come individuare queste caratteristiche. Potrebbe non essere il modo migliore in assoluto per riflettere sull’incertezza normativa fondamentale, ma sembra funzionare in molte situazioni e sembra anche piuttosto solido, nel senso che sembra difficile tirarci fuori implicazioni del tutto strampalate.

- Concentratevi di più su obiettivi adatti e sul breve periodo. In una situazione in cui sembra sempre più difficile formulare una visione coerente su come massimizzare il bene aggregato in un contesto cosmologico, il peso di altri tipi di cose che potremmo tenere in considerazione sembra sempre più grande. Se siete un po’ egoisti e un po’ altruisti e decidete che la componente altruista si trova su una scala di considerazioni del genere, allora forse dovreste affidarvi alla componente egoistica, finché – e a meno che – non trovate una stabilità nelle considerazioni altruiste.

- Concentratevi sullo sviluppare le capacità della nostra civiltà di riflettere con saggezza su questo genere di cose. Per espandere queste capacità, invece che perseguire obiettivi specifici, e con capacità in questo contesto, sembra che ci converrebbe concentrarci meno sul potere di fare certe cose e più sulla tendenza a usare quel potere. Concetto ancora un po’ nebuloso, ma qualcosa di questo tipo potrebbe essere la strada giusta da seguire. Certo, potrebbe saltare fuori una considerazione cruciale che dimostra che era la cosa sbagliata da fare, ma sembra comunque un’ipotesi ragionevole.

E questo è quanto. Grazie.